هوش مصنوعی هم اشتباه کرد!

مدلهای هوش مصنوعی در برابر توهمات و خطاهای بصری که ذهن انسان را فریب میدهند، چه واکنشی نشان میدهند؟ پژوهشگران آزمایشهایی را ترتیب دادهاند که باعث ایجاد خطای دید میشود و نتایج این آزمایشها، جنبههای جالبی از AI را آشکار کرد.

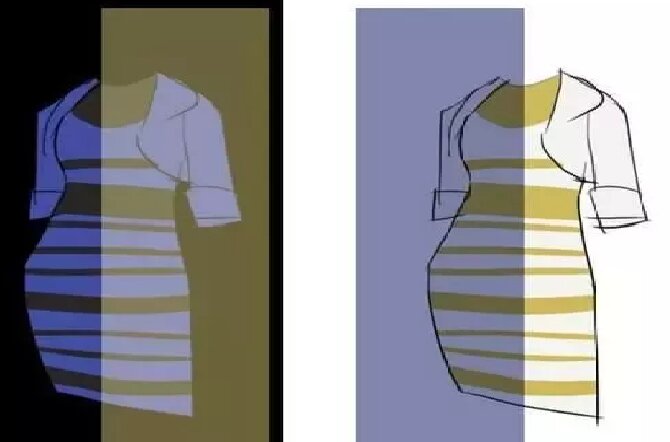

به گزارش هیچ یک : سیستم بینایی ما انسانها بهگونهای فرگشت یافته است که اجسام را به رنگهای ثابت در ذهن ما ثبت میکند؛ بنابراین چه زمان طلوع خورشید و چه زمانی که هوا تاریک است، حتی اگر برگ رنگهای مختلفی را منعکس کنند، شما بازهم برگها را سبز میبینید. چنین انطباقی در مغز ما باعث دیدن رنگهای کاذب و درنتیجه خطای دید میشود. پژوهشگران درآزمایشی، GPT-V4 (نسخه اخیر ChatGPT) را در معرض نوعی فریب بصری قرار دادند که موجب خطای دید در افراد میشود. پاسخهای این ربات اغلب با پاسخهای احتمالی افراد مطابقت داشت.

ازآنجاییکه دانشمندان، GPT را با تصویری که خطای دید رنگی داشت امتحان کردند، در ابتدا تصور کردند که شاید این ربات دادههای تصاویر را پردازش میکند و با حذف بخشی از آنها به پاسخ میرسد. اما به گفته OpenAI، چتجیپیتی دمای رنگ یا سایر ویژگیهای تصویر را قبل از تفسیر GPT-V4 تنظیم نمیکند. بنابراین محقق این آزمایش بر این باور است که این امکان وجود دارد که ربات، زبان بینایی را یاد گرفته و رنگ را در متن تفسیر کند، اشیاء درون تصویر را در مقایسه با یکدیگر ارزیابی کند و پیکسلها را بر این اساس، مشابه آنچه مغز انسان انجام میدهد، ارزیابی کند.

محققی دیگر که با این نظر موافق است، توضیح میدهد که این مدل میتواند رنگها را مانند انسانها بهصورت متنی یاد بگیرد، شیئی را شناسایی کند و برای شکل ظاهری این شیء پاسخ داشته باشد. بهعنوانمثال، در مورد لباسی که چند سال قبل در فضای مجازی موردبحث قرارگرفته بود، دانشمندان فکر میکنند که افراد مختلف، بر اساس فرضیات خود در مورد منبع نوری که باعث دیده شدن رنگ پارچه میشود، رنگها را به دو روش متفاوت تفسیر کردند.

او میگوید این واقعیت که مدل هوش مصنوعی میتواند تصاویر را به روشی مشابه ما تفسیر کند، به درک ما از اینکه AI چگونه مجموعه مهارتهای مشابهی را توسعه میدهد، کمک میکند. به بیان سادهتر اگر الگوریتمی که از دادههای آموزشی زیادی تغذیه میکند، شروع به تفسیر ذهنی رنگها کند، به این معنی است که ادراک انسان و ماشین ممکن است حداقل در این مورد نزدیک به هم باشند.

بااینحال همانطور که مطالعات اخیر نشان میدهد، این مدلها در موارد دیگر بههیچوجه مانند ما رفتار نمیکنند. این واقعیتی است که تفاوتهای کلیدی را بین نحوه «دیدن» مردم و ماشینها به جهان نشان میدهد. برخی از محققان دریافتهاند که مدلهای ترانسفورماتور توسعهیافته زبان بینایی جدید به توهمات متناقض پاسخ میدهند. گاهی اوقات آنها مانند انسان پاسخ میدهند. در موارد دیگر، آنها پاسخهای کاملاً منطقی و عینی دقیق ارائه میدهند. اما گاهی اوقات پاسخهای آنها بهگونهای است که گویا نتیجه توهم است.

انگیزه پشت چنین مطالعاتی آن نیست که بخواهیم ثابت کنیم انسانها و هوش مصنوعی شبیه یکدیگرند. تفاوت اساسی بین آنها این است که مغز ما پر از اتصالات غیرخطی و حلقههای بازخوردی است که سیگنالها را به عقب و جلو میفرستند.

یک عصبشناس محاسباتی از دانشگاه یورک در اونتاریو که در آزمایشهای خطای دید مشارکتی نداشت، میگوید: «همانطور که چشمها و سایر دستگاههای حسی ما اطلاعاتی را از دنیای بیرون جمعآوری میکنند، این شبکههای تکراری به مغز ما کمک میکنند تا هر شکافی را پر کند. اگرچه برخی از شبکههای عصبی مکرر برای تقلید از این جنبه از مغز انسان ایجاد شدهاند، بسیاری از مدلهای یادگیری ماشینی طوری طراحی نشدهاند که دارای اتصالات تکراری و دو جهته باشند».

محبوبترین مدلهای هوش مصنوعی ترانسفورماتور مولد بر توابع ریاضی مبتنی بر Feed Forward هستند. این بدان معناست که اطلاعات از طریق آنها فقط در یکجهت حرکت میکند: از ورودی به خروجی. مطالعه نحوه واکنش چنین سیستمی از هوش مصنوعی به خطای دید، میتواند به دانشمندان کمک کند تا تواناییها و سوگیریهای این مدلهای یادگیری ماشینی یکطرفه را بهتر درک کنند.

به گفته تیمی از دانشمندان کامپیوتر که چهار مدل زبان بینایی منبع باز را ارزیابی کردند، یکی از عوامل تأثیرگذار، اندازه مدل است. محققان دریافتند که مدلهای بزرگتر، یعنی مدلهایی که با وزنها و متغیرهای بیشتری توسعهیافتهاند، در مقایسه با مدلهای کوچکتر، با پاسخهای انسان به خطاهای دید هماهنگترند.

بهطورکلی، مدلهای هوش مصنوعی که دانشمندان آزمایش کردند، بهویژه در تثبیت عناصر توهمآمیز در یک تصویر خوب عمل نکردند بهطور میانگین کمتر از ۳۶ درصد دقت داشتند. آنها بهطور متوسط تنها حدود ۱۶ درصد موارد با پاسخهای انسان همسو بودند. بااینحال، این مطالعه همچنین نشان داد که مدلها در واکنش به انواع خاصی از خطای دید نسبت به سایر مدلها با دقت بیشتری از انسان تقلید میکنند.

بهعنوانمثال پاسخ این مدلها در خصوص خطای دید، یکی از شبیهترین خروجیهای انسانی را به همراه داشت. محققان با روشی خاص از مدلها خواستند تا در مورد تصاویر قضاوت کنند. آنها در نظر گرفته بودند که اگر این هوش مصنوعی در پاسخهای خود ۷۵ درصد به ادراک خطای دید انسانی نزدیک باشند، این مدل را «انسانمانند» خطاب کنند.

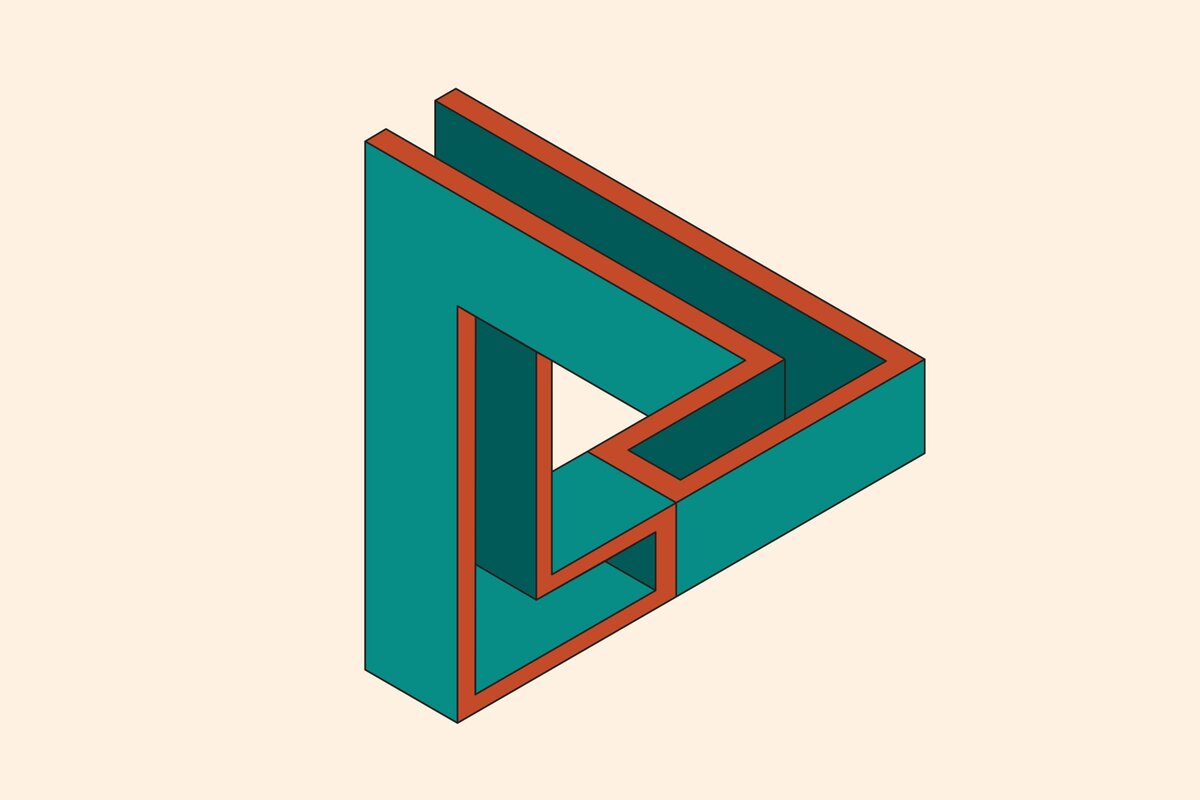

در پژوهشی دیگر که قبلاً منتشرشده بود، محققان تواناییهای GPT-۴V و Gemini-Pro گوگل را برای ارزیابی ۱۲ دسته مختلف از خطای دید آزمایش کردند. اینها توهمات شامل اشیاء غیرممکن است که بهنوعی شکلهای دوبعدی اجسامی هستند که نمیتوانند در فضای سهبعدی وجود داشته باشند و توهمات تصویری پنهان که در آن سایههای اجسام در یک تصویر گنجانده میشوند بدون اینکه بلافاصله آشکار شوند.

در ۹ مورد از ۱۲ دسته، مدلها در تشخیص آنچه در خطای دید اتفاق میافتد، در مقایسه با افراد بدتر بودند و میانگین دقت ۵۹ درصد در مقابل ۹۴ درصد پاسخدهندگان انسانی داشتند. اما در سه دسته خطای دید رنگ، زاویه و اندازه GPT-۴V بهطور قابلمقایسه یا حتی کمی بهتر از بازبینان انسانی عمل کرد.

یکی از نویسندگان این پژوهش از آزمایشگاه هوش مصنوعی خدمات وب آمازون، بر این باور است که این تفاوت به آن بستگی دارد که تجزیهوتحلیل خطاهای دید و توهمات به استدلال کمی یا کیفی نیاز دارد. انسانها در هر دو کار مهارت دارند، اما ممکن است مدلهای یادگیری ماشینی آمادگی کمتری برای قضاوت بر اساس چیزهایی داشته باشند که بهراحتی قابلاندازهگیری نیستند. هر سه دسته توهم که در آنها دستگاههای هوش مصنوعی در تفسیر بهترین بودند، علاوه بر ویژگیهای ذهنی شامل ویژگیهای قابلاندازهگیری کمی نیز هستند.

دانشمندان میگویند برای استقرار مسئولانه دستگاههای هوش مصنوعی، باید آسیبپذیریها و نقاط کور آنها و همچنین مکانهایی را که تمایلات انسانی تکرار میشوند و نمیشوند، درک کنیم. همسو شدن یک مدل با انسانها میتواند همانقدر که خوب باشد، بد هم باشد. همچنین در برخی موارد ابزارهایی مانند ابزارهای تشخیص پزشکی هوش مصنوعی که تصاویر رادیولوژی را تجزیهوتحلیل میکنند به این دلیل که در حالت آرمانی مستعد خطای بینایی نیستند، باعث خوشبینی نسبت به این نوع فناوری میشوند.

بنابراین، آزمایش خطای دید بر روی GPT-4V OpenAI و سایر مدلهای بزرگ یادگیری ماشینی که اغلب بهعنوان جعبههای سیاه توصیف میشوند میتوانند آنچه را واقعا در سر هوش مصنوعی میگذرد آشکار کند.